În ultimii ani, Nvidia a avut un mare succes prin orientarea sa către AI, deoarece modelele mari de limbaj și experiențele de „PC AI premium” accelerate de GPU par a fi cele mai noi tendințe în 2024. Cu toate acestea, companii mai noi și mai mici încearcă să-i acapareze cota de piață, companii de care probabil nu ai auzit niciodată.

Astfel, au existat dezvoltări în domeniul GPU-urilor în afara binecunoscutelor plăci grafice realizate de Nvidia și AMD pentru calculul AI. Unele dintre modelele mari de limbaj de astăzi rulează deja pe configurații cu GPU-uri și memorie interconectate, cum ar fi hardware-ul de la Cerebras.

Cerebras Systems Inc. a fost fondată acum doar nouă ani, dar pare să beneficieze masiv de pe urma boom-ului recent al industriei AI. Aceasta a inovat în moduri care par să pună în umbră modelul H100 de generație actuală și viitorul cip GB200 cu un „cip unic, enorm” ce folosește până la 900.000 de nuclee GPU – cum ar fi cipul său CS-3.

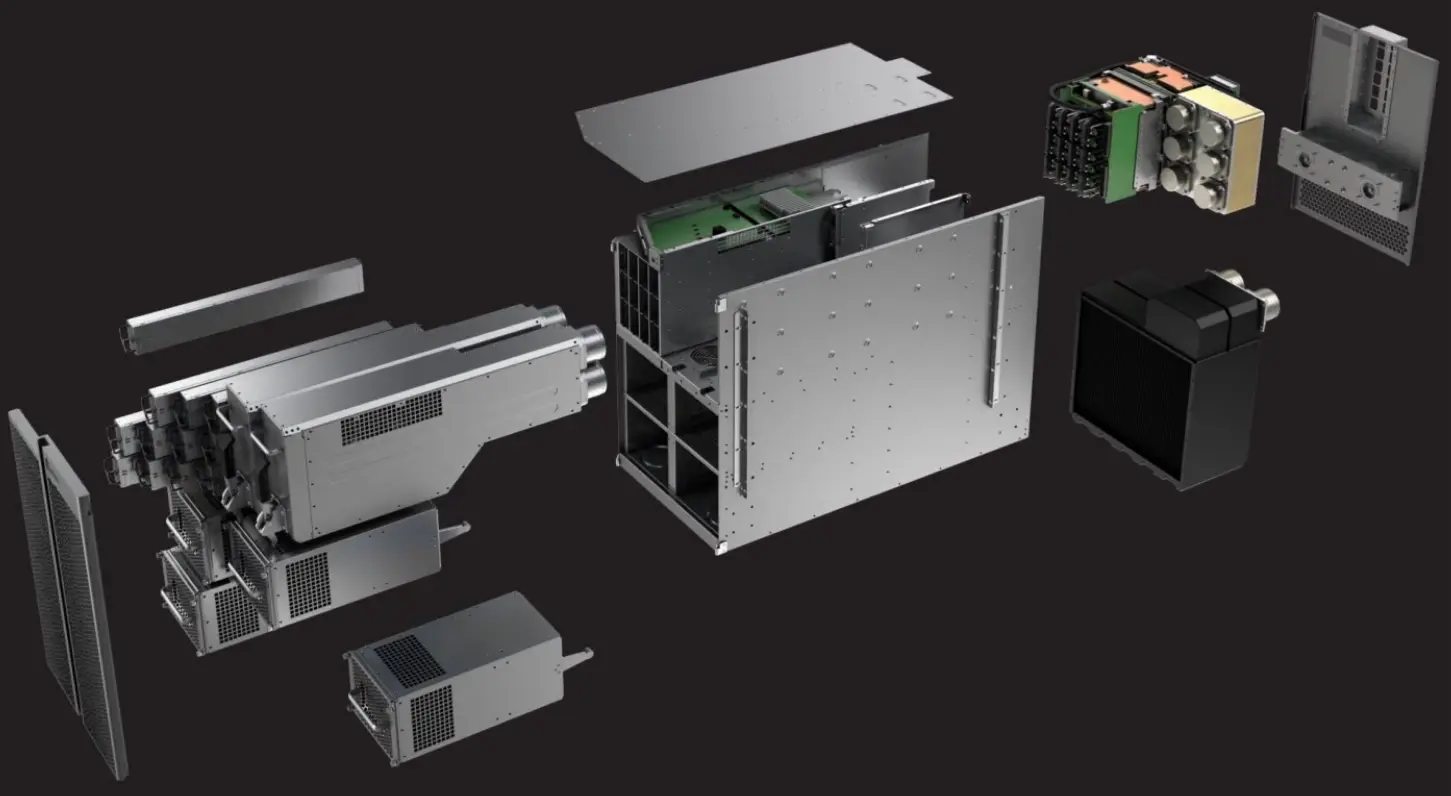

Cipul Cerebras CS-3 depășește cu mult dimensiunea dublă a imensului GB200 și are dimensiunea unei tablete mari, necesitând două mâini pentru a fi ținut. A fost descris de către producător ca fiind „cel mai rapid și mai scalabil accelerator AI din lume”, conceput special pentru a „antrena cele mai avansate modele AI din lume”.

Mai mult, producătorul american a subliniat că Wafer Scale Engine este „cipul care sfidează Legea lui Moore”. Conform benchmark-urilor sale interne, CS-3 se situează cu încredere deasupra H100, având un total de 10.000.000.000.000 de tranzistori. Ca referință, se estimează că GB200 va avea 208.000.000.000 de tranzistori, în timp ce CS-3 prezintă o creștere uluitoare de 4.707%.

Cu toate acestea, nu doar Cerebras face progrese în acest domeniu, deoarece și noua companie start-up Groq dezvoltă hardware pentru calculul AI. În loc să depășească concurența prin mărime, Groq a dezvoltat ceea ce numește LPU-uri dedicate (unități de procesare a limbajului) care sunt construite pentru a rula modele mari de limbaj eficient și rapid.

În cuvintele proprii ale companiei, motorul de inferență Groq LPU este un „sistem de accelerare a inferenței end-to-end, pentru a oferi performanță, eficiență și precizie substanțiale într-un design simplu”. În prezent, rulează modelul Llama-2 70B, un model generativ de limbaj și text la scară mare.